服务器显卡 GPU加速 为什么服务器需要安装独立显卡?解析其在计算与图形处理中的重要作用

- 问答

- 2025-08-16 06:17:54

- 4

本文目录导读:

🌐 深夜的数据中心里,小王盯着屏幕上疯狂跳动的进度条直挠头——原本预计8小时完成的AI模型训练,CPU集群跑了12小时才完成60%,这时主管拍拍他肩膀:"该给服务器装块专业显卡了。" 这个真实场景,正揭示着现代服务器架构的进化密码。

🚀 当CPU遇到"算力天花板"

传统服务器依赖CPU进行通用计算,但遇到以下场景就会"力不从心":

- 🧠 深度学习训练时,需要同时处理数百万个神经元参数

- 🌍 气象模拟中,每个时间步长都要计算全球百万个网格点的物理变化

- 🎞️ 4K视频转码时,每帧画面都需要复杂的色彩空间转换

CPU的串行处理架构就像用勺子挖井,而GPU的数千个流处理器则是同时工作的钻头队,以NVIDIA A100为例,其FP32算力达19.5TFLOPS,相当于同时运行1000个高性能CPU核心。

🧩 GPU加速的三大战场

科学计算领域

在基因测序分析中,GPU可将比对速度提升30倍;在量子化学模拟里,NVIDIA H100能将分子动力学计算时间从周级压缩到小时级,最新研究显示,采用GPU加速的天气预报模型,空间分辨率可从25公里提升至3公里。

人工智能革命

Transformer架构的崛起让GPU成为刚需,训练GPT-3级模型需要:

- 📈 1024块A100显卡组成的集群

- 🕒 持续34天的稳定运行

- 💡 产生1.2TB的中间计算数据

这种算力需求催生了DGX A100这样的整机柜方案,其内部采用NVLink互连技术,GPU间带宽高达600GB/s。

图形处理进化

影视后期制作中,单块RTX 6000 Ada显卡可实时渲染:

- 🎬 8K分辨率的3D场景

- 🌈 包含1000个动态光源的复杂光照

- 🧬 基于神经网络的降噪处理

游戏服务器领域,NVIDIA Grace Hopper超级芯片已实现:

- 🎮 200人同服的物理碰撞计算

- 🌐 动态加载的1000平方公里开放世界

- 📱 移动端120fps的云游戏串流

💡 企业级显卡的特殊本领

不同于游戏显卡,服务器级GPU具备:

- 🔄 ECC内存纠错(单比特错误自动修复)

- 📊 硬件级虚拟化(每个VM可分配独立vGPU)

- 🔌 热插拔设计(7×24小时运行可靠性达99.999%)

AMD Instinct MI300X的创新:

- 🧬 融合CPU+GPU的3D堆叠技术

- 📦 128GB HBM3显存(带宽5.3TB/s)

- 🌐 支持ROCm 5.0开放生态

💰 投资回报率计算器

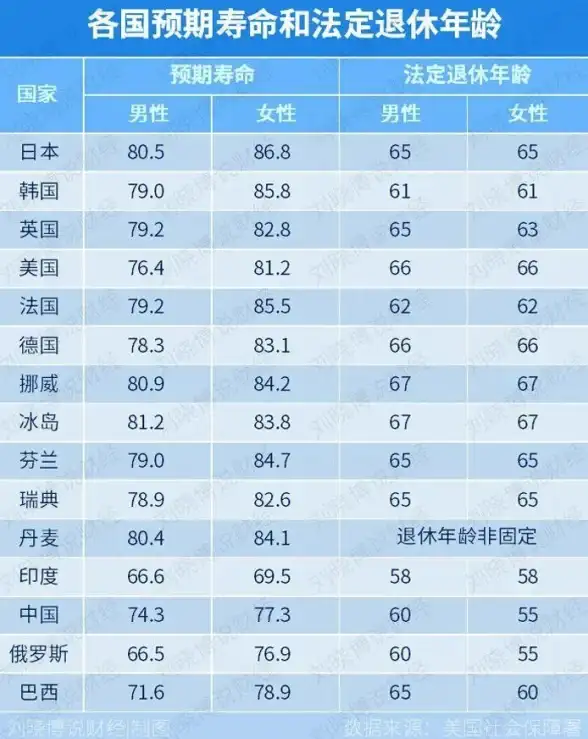

以10台服务器集群为例: | 配置 | 初始成本 | 年运维费 | 任务耗时 | 三年TCO | |--------------|----------|----------|----------|---------| | CPU-only | $12万 | $3.6万 | 48小时 | $22.8万 | | GPU加速方案 | $25万 | $4.8万 | 8小时 | $19.2万 |

节省的23%总成本中,60%来自任务时间缩短带来的机会收益。

🔮 未来技术展望

2025年Q3即将发布的NVIDIA Blackwell架构将带来:

- 🧠 2000亿晶体管设计

- 🔗 第五代NVLink(18TB/s双向带宽)

- 🌐 支持CX-7以太网(51.2Tbps交换能力)

在量子计算与经典计算的混合架构中,GPU正成为衔接二者的关键桥梁,正如OpenAI首席科学家Ilya Sutskever所言:"没有GPU的加速,现代AI研究将倒退十年。"

💡 小贴士:选择服务器显卡时,注意PCIe通道数(x16最佳)、功耗墙设置(建议预留30%冗余)、以及是否支持SR-IOV虚拟化技术,2025年的新标准PCIe 7.0将带来256GB/s的单向带宽,值得持续关注。

本文由 业务大全 于2025-08-16发表在【云服务器提供商】,文中图片由(业务大全)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/631807.html

发表评论