云平台 数据集成 利用迁移工具提升云计算环境中的互操作性与兼容性

- 问答

- 2025-08-09 18:28:03

- 4

如何用迁移工具打破云计算环境的互操作性困局

2025年8月最新动态:根据全球云服务市场分析报告,超过70%的企业仍在混合云或多云环境中遭遇数据互通难题,某知名电商平台近日因跨云数据同步延迟导致促销活动故障,再次凸显了兼容性优化的重要性。

当云平台说"方言":数据集成的现实挑战

想象一下:你公司的客户数据躺在AWS的Redshift里,财务系统跑在Azure SQL Database上,而营销团队却用Google BigQuery做分析,这就像让说英语、中文和西班牙语的三个团队开晨会——没有翻译工具,全是鸡同鸭讲。

这就是2025年云计算的真实写照,虽然各云厂商都宣称支持开放标准,但实际操作中:

- API的"方言"差异:同样查询操作,AWS的CLI和Azure PowerShell语法能差出十八条街

- 数据格式的潜规则:JSON字段大小写敏感?时间戳用UTC还是本地时区?每个平台都有自己的小脾气

- 网络性能玄学:跨云传输时,那神秘的200ms延迟总在关键时刻出现

迁移工具的"瑞士军刀"效应

去年某制造业客户的故事很典型:他们用开源工具把SAP数据从本地机房迁移到阿里云,结果发现工单系统的日期字段全乱了——原来本地系统用"DD/MM/YYYY",而云数据库默认"YYYY-MM-DD",后来改用专业迁移工具,这些问题在预处理阶段就被自动修正。

现代数据迁移工具正在进化出三大超能力:

智能Schema翻译机

就像同声传译员能实时转换语言,工具如AWS DMS或Azure Data Factory现在可以:

- 自动映射不同数据库的字段类型(比如Oracle的NUMBER到PostgreSQL的BIGINT)

- 识别并转换字符编码(GB2312转UTF-8?小菜一碟)

- 智能处理时区转换,再也不用担心纽约时间戳存成了北京时间

数据管道的缓冲魔法

某游戏公司曾因直接同步导致云数据库过载崩溃,现在迁移工具都学会了"温柔操作":

- 动态调节传输速率(业务高峰时自动限流)

- 内存缓冲池设计(突然断网?已传输数据不会丢失)

- 自动重试机制(遇到API限流就歇会儿再试)

校验界的"大家来找茬"

金融客户最爱的功能:传输完成后自动生成差异报告,比如发现目标库比源库少3条记录,会精确定位到是哪些ID丢失,甚至能自动修复。

实战避坑指南

最近帮某零售客户做多云集成时,我们总结出这些血泪经验:

测试环境的谎言

- 在测试环境跑通≠生产环境能用,务必用真实数据量的1%做压力测试

- 特别注意LOB字段(大文本/二进制),它们往往是性能杀手

元数据的暗礁

- 索引和约束不会自动迁移,需要额外脚本处理

- 权限体系要重新设计(本地AD账号和云IAM根本是两套体系)

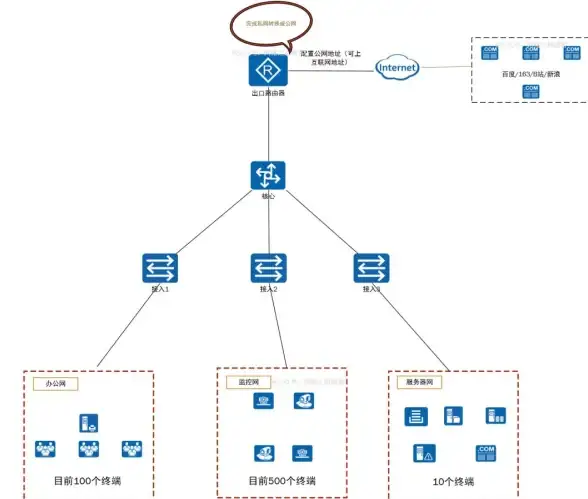

网络拓扑的蝴蝶效应

- 跨可用区传输费用可能是同区域的三倍

- 某些云厂商对出口数据收费,入口免费,这个细节能让你省下大笔银子

未来已来:AI驱动的自适应迁移

微软最近演示的Copilot for Data Migration已经能:

- 分析源数据和目标环境,自动推荐最优方案

- 在传输过程中动态优化(比如发现某个表特别大就自动分片)

- 生成白话文报告:"亲,有5个存储过程需要手动修改,因为用了Azure不支持的语法"

不过要提醒的是:再智能的工具也替代不了人的判断,就像自动驾驶汽车,关键时刻还需要老司机握紧方向盘。

云平台间的数据流动,本质上是在不同数字大陆之间架桥,好的迁移工具就像港珠澳大桥的沉管隧道——既要承受洋流冲击,又要让车辆平稳通行,2025年的选择很简单:要么花时间解决兼容性问题,要么花钱为数据孤岛买单,毕竟在这个时代,数据不通比血管堵塞更危险。

本文由 疏弘业 于2025-08-09发表在【云服务器提供商】,文中图片由(疏弘业)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/578978.html

发表评论