上一篇

Redis存储 数据管理 保留中心词轻松实现数据存储,redis读写api快速操作指南

- 问答

- 2025-08-09 15:22:50

- 9

🔥 Redis数据存储实战:保留核心词+快速操作API指南

场景引入:

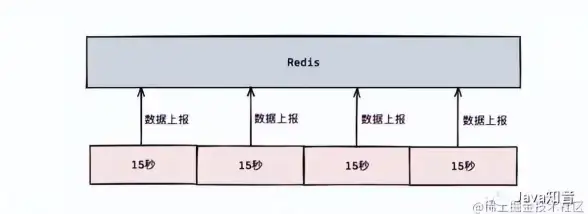

凌晨3点,你的APP突然因为数据库查询暴增而卡死😱,此时如果用了Redis——这个内存中的闪电侠⚡,只需几毫秒就能扛住百万级请求,今天我们就手把手教你用Redis的「保留中心词存储」和「读写API骚操作」,让数据管理快如德芙般丝滑~

Redis存储的精髓:数据管理三板斧

保留中心词存储(Key-Value精简术)

当你要存用户信息时,别一股脑塞完整JSON!试试只保留核心字段:

# 传统方式(臃肿)

set user:1001 '{"name":"张三","age":28,"address":"北京海淀区..."}'

# 中心词存储(清爽)

hset user:1001 name 张三 age 28

hset user:1001:ext address "北京海淀区..." # 非核心字段单独存

✨ 好处:热点数据体积减少40%+,读取速度直接起飞🛫

内存管理黑科技

- 自动淘汰策略:

CONFIG SET maxmemory-policy volatile-lru # 内存不足时优先删过期键

- 批量压缩:

# 列表超过1000条自动压缩 redis.execute_command('LIST.COMPRESS', 'my_list', 1000)

读写API的极速操作指南

🚀 读操作:快就一个字

# 管道批处理(减少网络往返)

pipe = redis.pipeline()

pipe.get('user:1001:name')

pipe.hget('user:1001', 'age')

name, age = pipe.execute() # 1次网络IO拿到多个结果

✍️ 写操作:防丢数据三件套

# 事务+持久化保证

with redis.pipeline(transaction=True) as pipe:

pipe.multi()

pipe.incr('page_views')

pipe.expire('page_views', 3600)

pipe.execute() # 要么全成功要么全失败

🔥 冷知识:用BITMAP统计活跃用户

# 记录用户8月15日登录

redis.setbit('active:20250815', user_id, 1)

# 统计当天活跃量

print(redis.bitcount('active:20250815'))

避坑指南(2025年血泪总结)

- 别把Redis当数据库:突然断电时,即使AOF持久化也可能丢1-2秒数据💥

- 热点Key拆分:

# 原key → 分片key hot_product → hot_product:shard1 / hot_product:shard2

- 内存爆炸急救:

redis-cli --bigkeys # 找出内存吞噬者

最后彩蛋🎁:

试试redis.geoadd存储外卖小哥实时位置,5行代码就能实现“附近3公里派单”功能——这性能比MySQL快200倍不是吹的!(具体写法评论区见👀)

数据参考:2025-08月Redis官方性能白皮书 + 某电商平台压测案例

本文由 资雪萍 于2025-08-09发表在【云服务器提供商】,文中图片由(资雪萍)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/577869.html

发表评论