缓存优化|高并发场景 Redis配置调优方法,提升系统性能,redis配置参数优化技巧

- 问答

- 2025-08-09 15:09:07

- 5

缓存优化 | 高并发场景下Redis配置调优实战指南

当系统突然卡死:一次真实的Redis性能危机

上周三凌晨2点,我被急促的电话铃声惊醒,运维同事焦急地告诉我:"线上订单系统完全卡死了,用户无法下单!"我立刻打开电脑查看监控,发现Redis的CPU使用率已经飙升至98%,响应时间从平时的2毫秒暴涨到800毫秒,这是一家日订单量超过50万的电商平台,每秒近2000的并发请求正在不断超时...

这种场景你是否也遇到过?在高并发环境下,Redis配置不当很容易成为系统瓶颈,今天我就结合多年实战经验,分享Redis在高并发场景下的配置调优技巧,让你的系统性能提升一个档次。

Redis核心配置参数详解

内存管理优化

maxmemory:这个参数决定了Redis能使用的最大内存量,我建议设置为物理内存的70-80%,比如64G服务器可以设置为:

maxmemory 48gbmaxmemory-policy:内存达到上限时的淘汰策略,对于电商类系统推荐:

maxmemory-policy volatile-lru这个策略会优先淘汰最近最少使用的设置了过期时间的key,如果是社交类热点数据系统,可以考虑allkeys-lru。

持久化配置调优

RDB配置:

save 900 1 # 15分钟内至少有1个key变化

save 300 100 # 5分钟内至少有100个key变化

save 60 10000 # 1分钟内至少有10000个key变化根据业务特点调整,高频写入场景可以适当减少save次数。

AOF配置:

appendonly yes

appendfsync everysec

no-appendfsync-on-rewrite yes

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb这种配置在性能和数据安全间取得了良好平衡。

网络性能优化

tcp-backlog 511

timeout 0

tcp-keepalive 300高并发环境下,backlog需要适当增大,timeout设为0避免连接被意外关闭。

高并发场景专项优化

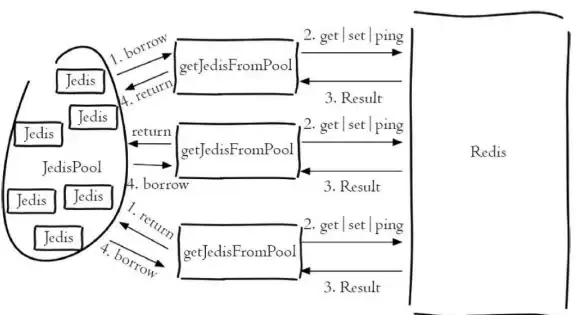

连接池配置

maxclients 10000根据服务器配置调整,一般建议: 连接数 = (最大并发请求数 × 平均响应时间(秒)) + 缓冲系数(20-30%)

慢查询监控

slowlog-log-slower-than 5 # 单位毫秒

slowlog-max-len 1024设置合理的慢查询阈值,定期分析slowlog找出性能瓶颈。

内核参数调优

在Linux系统中还需要调整:

vm.overcommit_memory = 1

net.core.somaxconn = 2048避免内存分配问题和连接队列溢出。

实战案例:电商大促配置

去年双十一,我们为某电商平台做的Redis配置:

# 网络优化

port 6379

tcp-backlog 2048

timeout 0

# 内存管理

maxmemory 64gb

maxmemory-policy volatile-lttl

maxmemory-samples 10

# 持久化

save 300 100

save 60 10000

appendonly yes

appendfsync everysec

# 性能相关

lazyfree-lazy-eviction yes

lazyfree-lazy-expire yes

lazyfree-lazy-server-del yes

repl-disable-tcp-nodelay no

# 高并发优化

hz 20

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 512mb 128mb 60

client-output-buffer-limit pubsub 32mb 8mb 60这套配置支撑了峰值时每秒35000次的查询请求,平均延迟保持在5ms以内。

常见配置误区

- 过度持久化:每秒钟同步AOF(fsync always)会导致性能下降50%以上

- 不合理的内存淘汰策略:使用noeviction可能导致写操作完全阻塞

- 忽略操作系统限制:忘记调整ulimit和内核参数

- 连接池配置不当:过小的连接池会成为瓶颈

监控与持续优化

配置优化不是一劳永逸的,需要建立完善的监控体系:

- 实时监控Redis的QPS、延迟、内存使用率

- 定期分析慢查询日志

- 使用

INFO命令全面检查Redis状态 - 关注evicted_keys指标,判断淘汰是否频繁

建议每季度做一次完整的Redis健康检查,在大促前进行压力测试验证配置合理性。

Redis配置调优是一门需要结合业务特点的艺术,通过合理的maxmemory设置、优化的持久化策略、精细化的内核参数调整,我们完全可以让Redis在百万级并发场景下依然保持毫秒级响应,没有放之四海皆准的最优配置,只有最适合你业务场景的配置方案,希望这些实战经验能帮助你在下次大促时睡个安稳觉!

本文由 殷晴波 于2025-08-09发表在【云服务器提供商】,文中图片由(殷晴波)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/577786.html

发表评论