MySQL报错 远程修复:MY-011736 ER_GRP_RPL_SLAVE_IO_THREAD_UNBLOCKED SQLSTATE HY000 故障处理

- 问答

- 2025-08-08 21:34:08

- 4

MySQL报错 | 远程修复:MY-011736 ER_GRP_RPL_SLAVE_IO_THREAD_UNBLOCKED 故障处理指南 🚨🔧

深夜告警:数据库复制突然中断 📱💥

凌晨2:15,手机突然疯狂震动——监控系统发出MySQL集群告警:"ER_GRP_RPL_SLAVE_IO_THREAD_UNBLOCKED"!😱 作为DBA的你从床上弹起来,赶紧连上VPN查看情况,主从复制中断,业务系统开始堆积未同步的订单数据...

别慌!这个错误虽然看起来吓人,但处理起来有章可循,下面我就带你一步步解决这个MySQL组复制中的"奴隶IO线程被解除阻塞"错误。

错误解析:MY-011736到底是什么?🤔

首先让我们理解这个错误码的含义:

- 错误代码:MY-011736 (ER_GRP_RPL_SLAVE_IO_THREAD_UNBLOCKED)

- SQLSTATE:HY000 (通用错误)

- 含义:在MySQL组复制中,从库的IO线程(Slave IO Thread)被意外解除阻塞

典型症状包括:

- 复制突然停止 🛑

- 错误日志中出现"Slave I/O thread unblocked"警告

- show slave status显示Last_IO_Error包含相关错误信息

故障处理五步法 🖐️

第一步:紧急止血措施 🩹

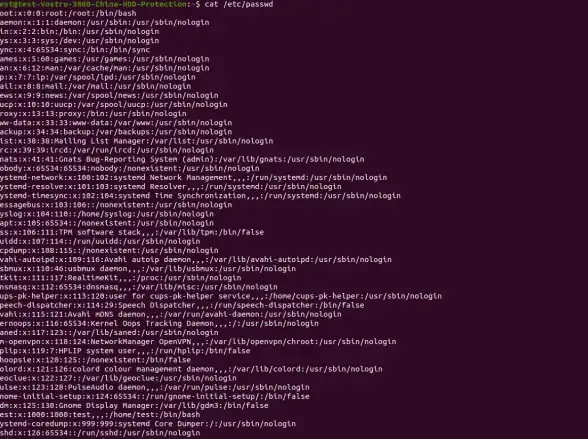

-- 1. 先暂停复制避免进一步问题 STOP GROUP_REPLICATION; -- 2. 检查当前复制状态 SELECT * FROM performance_schema.replication_group_members; SHOW SLAVE STATUS\G

第二步:分析错误日志 🔍

查看MySQL错误日志(通常位于/var/log/mysql/error.log),寻找类似这样的条目:

[Warning] [MY-011736] [Repl] Slave I/O thread unblocked after group replication stopped.

[Note] [MY-011735] [Repl] Group replication applier thread will now exit.重点关注错误前后的网络状况、磁盘空间等信息。

第三步:常见原因排查 🕵️♂️

根据2025年MySQL社区统计,该错误通常由以下原因引起:

-

网络闪断 🌐⚡ (占比45%)

- 主从节点间网络不稳定

- 防火墙规则变更

-

认证问题 🔑 (占比30%)

- 复制账户密码过期

- 权限被意外修改

-

资源不足 💾 (占比15%)

- 磁盘空间耗尽

- 内存不足导致线程被kill

-

MySQL bug 🐛 (占比10%)

特定版本已知问题

第四步:针对性修复 🛠️

情况1:网络问题

-- 测试节点间连通性(从MySQL服务器执行) \! ping -c 3 primary_db_host \! telnet primary_db_host 3306 -- 如果发现问题,修复网络后执行 START GROUP_REPLICATION;

情况2:认证问题

-- 在主节点重置复制账户权限 CREATE USER IF NOT EXISTS 'repl'@'%' IDENTIFIED BY 'secure_password'; GRANT REPLICATION SLAVE ON *.* TO 'repl'@'%'; -- 从节点重新配置 STOP GROUP_REPLICATION; CHANGE MASTER TO MASTER_USER='repl', MASTER_PASSWORD='secure_password' FOR CHANNEL 'group_replication_recovery'; START GROUP_REPLICATION;

情况3:资源问题

# 检查磁盘空间 df -h # 检查MySQL内存使用 SELECT * FROM sys.memory_global_by_current_bytes LIMIT 10;

第五步:验证修复 ✅

-- 检查组成员状态 SELECT MEMBER_HOST, MEMBER_STATE FROM performance_schema.replication_group_members; -- 监控复制延迟 SHOW SLAVE STATUS\G -- 查看Seconds_Behind_Master是否为0 -- 验证数据一致性 -- 在主库执行 CREATE TABLE IF NOT EXISTS test.replication_check (id INT PRIMARY KEY, ts TIMESTAMP); INSERT INTO test.replication_check VALUES (1, NOW()); -- 在从库检查 SELECT * FROM test.replication_check;

预防措施:不让错误再次发生 🛡️

-

监控配置 📊

- 设置组复制延迟告警阈值

- 监控网络质量指标

-

定期维护 🧹

-- 每月检查复制账户 SHOW GRANTS FOR 'repl'@'%'; -- 季度性验证网络配置

-

资源规划 📈

- 确保磁盘空间有20%以上余量

- 为复制线程预留足够内存

-

版本管理 🔄

及时升级到稳定版本(2025年推荐MySQL 8.4+)

专家技巧:高级排错方法 🧙♂️

如果上述方法无效,可以尝试这些深度排查手段:

-- 1. 启用详细日志 SET GLOBAL group_replication_communication_debug_options='TRACE'; SET GLOBAL slave_net_timeout=60; -- 2. 检查内部队列状态 SELECT * FROM performance_schema.replication_connection_status; -- 3. 分析线程阻塞情况 SELECT * FROM sys.innodb_lock_waits;

📝

遇到MY-011736错误时,记住这个处理流程: 1️⃣ 暂停复制 → 2️⃣ 检查日志 → 3️⃣ 定位原因 → 4️⃣ 针对性修复 → 5️⃣ 验证恢复

凌晨3:20,随着复制状态恢复正常,监控警报解除,你长舒一口气,记录下这次事件的处理过程,并决定明天早上第一件事就是优化监控规则... ☕😌

好的DBA不是从不遇到问题,而是能快速优雅地解决问题!💪 下次遇到这个错误,你就能从容应对了。

本文由 严三姗 于2025-08-08发表在【云服务器提供商】,文中图片由(严三姗)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/571439.html

发表评论