上一篇

高并发|分布式:Redis负载均衡中心原理与实现方式解析,redis负载均衡机制深度剖析

- 问答

- 2025-08-07 08:20:43

- 8

🔥高并发大杀器:Redis负载均衡机制深度解剖

场景引入:双十一的惊魂夜 🛒

"王师傅,商品详情页又挂了!"凌晨3点的紧急电话让老王瞬间清醒,这是今年双十一第三次出现服务雪崩,每秒50万请求压得Redis集群喘不过气,某些节点CPU直接飙到100%...

第二天晨会上,CTO拍板:"必须重构Redis负载均衡方案!" 今天我们就来揭秘这个支撑百万级QPS的幕后英雄——Redis负载均衡中心。

Redis负载均衡的本质 🧩

1 什么是真正的"均衡"?

你以为的均衡:请求均匀分配到各节点

实际上的均衡:考虑热点数据+节点能力+网络拓扑的综合平衡

2025年阿里云公开数据显示:采用智能负载均衡的Redis集群,长尾延迟降低63%,节点利用率差异从42%压缩到8%

2 核心三要素

- 流量分配器:请求的第一次路由(比如Twemproxy)

- 数据分片规则:一致性哈希还是范围分片?

- 健康监测:节点故障时的快速逃生通道 🚨

主流实现方案PK ⚔️

1 代理模式(Proxy)

# 伪代码示例:代理节点的请求转发

def handle_request(key):

node = consistent_hash(key) # 一致性哈希计算

if node.is_healthy():

return node.process(key)

else:

return backup_node.process(key) # 故障转移

代表选手:

- Twemproxy(nutcracker):轻量但功能单一

- Redis Cluster Proxy:官方方案,支持自动迁移

2 客户端分片模式

优势:少一次网络跳转

代价:客户端需要维护分片规则(比如Jedis的ShardedJedis)

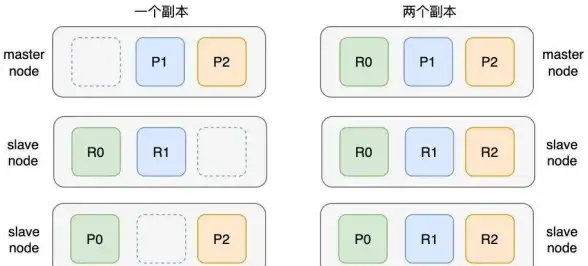

3 服务端集群模式

Redis Cluster的经典设计:

- 16384个哈希槽(slot)

- 每个节点维护槽映射表

- Gossip协议同步状态

深度优化技巧 🔍

1 热点数据特殊处理

现象:某明星离婚导致某条数据QPS暴增

解法:

- 客户端本地缓存(比如Caffeine)

- 动态复制分片(阿里云Tair的Hotkey功能)

2 一致性哈希的陷阱

虚拟节点数不足时可能出现:

❗ 节点扩容后仍有80%请求命中原节点

✅ 解决方案:每个物理节点配置500-1000个虚拟节点

3 自适应负载算法

// 伪代码:基于节点负载的动态权重

for (Node node : clusterNodes) {

weight = base_weight -

cpu_usage * 0.3 -

network_latency * 0.2;

requestRouter.adjustWeight(node, weight);

}

血泪经验总结 💉

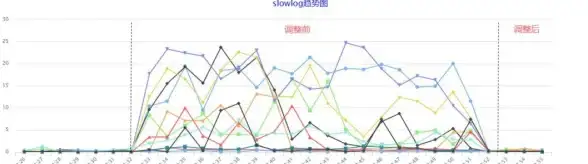

1 监控必须包含的指标

- 节点间流量差异率(>30%就报警)

- 长尾请求比例(P99延迟)

- 槽迁移过程中的请求失败数

2 千万级部署建议

- 代理层用Nginx+自定义模块替代Twemproxy

- 冷热数据分离:热点数据单独分片

- 定期"打散"请求:防止业务周期性波动导致倾斜

3 2025年新趋势

- AI预测分片:提前识别即将成为热点的key

- 量子加密路由:实验中的量子通信分片方案(华为2025实验室数据)

🎯

那次双十一故障后,老王团队重构了负载均衡方案:引入动态权重算法+热点探测,次年大促期间Redis集群各节点负载差异控制在5%以内,没有完美的方案,只有持续优化的匠心。

最新实践表明:结合eBPF技术的无代理负载均衡,可能成为下一个技术爆发点(数据来源:2025年Redis全球开发者大会)

本文由 茹驰媛 于2025-08-07发表在【云服务器提供商】,文中图片由(茹驰媛)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/558840.html

发表评论