Redis优化 线程管理 深入解析高性能Redis的线程阻塞机制与实现方法

- 问答

- 2025-08-06 20:45:05

- 3

Redis优化 | 线程管理 | 深入解析高性能Redis的线程阻塞机制与实现方法

场景引入:当Redis突然"卡顿"时

想象一下这个场景:凌晨三点,你正躺在床上做着美梦,突然手机开始疯狂震动——监控系统报警了!你揉揉眼睛一看,核心业务系统的Redis响应时间从平时的2毫秒飙升到了2000毫秒,用户投诉像雪花一样飞来,你一个激灵爬起来,连上服务器查看日志,发现Redis正在执行一个巨大的keys *操作...

这种"卡顿"现象在Redis运维中并不罕见,而背后往往与Redis独特的线程模型和阻塞机制有关,今天我们就来深入聊聊Redis的线程管理艺术,以及如何优化避免这类"午夜惊魂"。

Redis线程模型:单线程的智慧

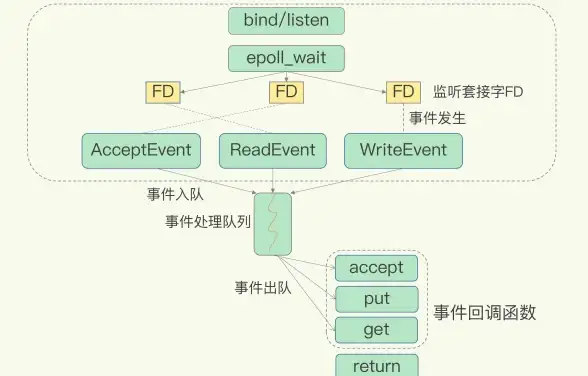

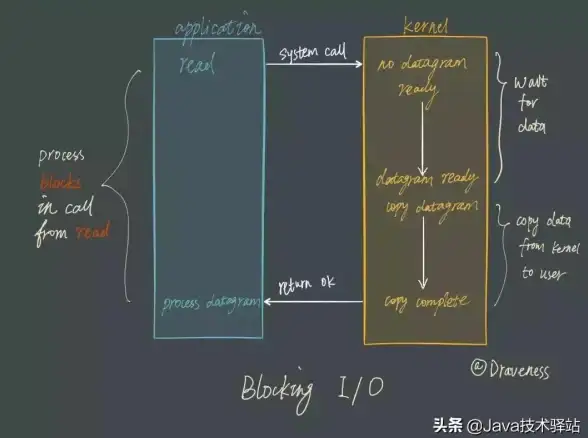

Redis的核心设计哲学是"简单即高效",不同于其他数据库的多线程架构,Redis 6.0之前一直采用单线程模型处理命令请求(网络I/O线程除外),这个设计看似违背直觉,实则暗藏玄机:

- 避免锁竞争:没有多线程就意味着不需要处理复杂的锁机制,减少了上下文切换和竞态条件

- 顺序执行:所有命令按到达顺序执行,天然避免了并发问题

- 内存操作:数据全部放在内存中,单线程足以发挥极致性能

但单线程也意味着一个长耗时命令会阻塞整个服务,这就是我们开头场景的根源,直到Redis 6.0,才引入了多线程I/O(注意:仍然是单线程命令处理)。

Redis阻塞的五大"罪魁祸首"

大Key操作

# 危险操作示例 DEL user:session:*

一个包含百万字段的Hash,或者一个超长List的BLPOP操作,都可能让Redis"卡住"好几秒。

优化方案:

- 使用SCAN+HSCAN等渐进式命令替代全量操作

- 大Hash拆分为多个小Hash

- 设置合理的超时时间:

{EX|PX} {NX|XX}

复杂Lua脚本

-- 可能导致阻塞的脚本

for i=1,1000000 do

redis.call('SET', 'key'..i, 'value')

end

Lua脚本在Redis中是原子执行的,长时间运行的脚本会阻塞其他命令。

优化方案:

- 脚本执行时间控制在毫秒级

- 使用

redis.replicate_commands()拆分大脚本 - 监控SCRIPT KILL使用情况

AOF持久化

当AOF rewrite时,如果开启了aof-rewrite-incremental-fsync,可能会导致主线程阻塞。

优化方案:

- 调整

aof-rewrite-incremental-fsync为适当值(默认32MB) - 使用更快的存储设备

- 考虑RDB+AOF混合模式

内存淘汰策略

当内存达到maxmemory时,按策略淘汰key可能引起延迟,特别是volatile-lru等需要计算策略。

优化方案:

- 选择

allkeys-lru等计算量小的策略 - 提前扩容,避免频繁淘汰

- 监控

evicted_keys指标

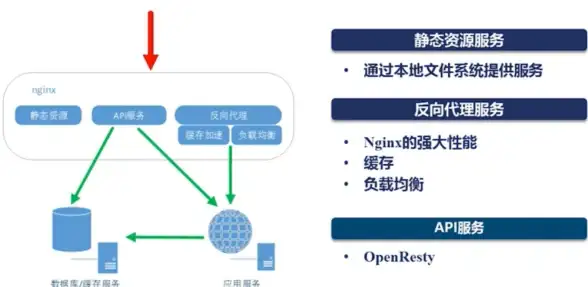

网络I/O瓶颈

虽然Redis 6.0+支持多线程I/O,但如果配置不当仍可能成为瓶颈。

优化方案:

- 合理设置

io-threads(通常为CPU核心数的3/4) - 启用

io-threads-do-reads(Redis 7.0+) - 使用连接池避免频繁建连

线程阻塞的深度检测方法

慢查询日志

CONFIG SET slowlog-log-slower-than 10000 # 10毫秒 SLOWLOG GET 10 # 查看最近10条慢查询

监控命令统计

INFO commandstats

重点关注calls和usec_per_call异常的命令

延迟监控

redis-cli --latency -h 127.0.0.1 -p 6379

内核级观测

perf top -p `pidof redis-server` strace -p `pidof redis-server` -T -tt -o redis_trace.log

高级优化技巧

线程池优化(Redis 6.0+)

# redis.conf io-threads 4 io-threads-do-reads yes

注意:线程数不是越多越好,建议设置为CPU核心数的3/4

客户端缓冲控制

# 防止客户端输出缓冲区爆满 client-output-buffer-limit normal 256mb 128mb 300 client-output-buffer-limit pubsub 512mb 128mb 300

内存碎片整理

CONFIG SET activedefrag yes hz 10 # 适当提高频率

合理设置超时

# 防止长时间阻塞 timeout 300 # 客户端空闲超时(秒) tcp-keepalive 60 # TCP保活

实战案例:电商秒杀系统优化

某电商平台在大促时遇到Redis间歇性卡顿,经排查发现:

- 热点商品查询QPS高达50万+

- 存在

HGETALL操作百万字段的Hash - Lua脚本平均执行时间达800ms

优化方案:

- 将大Hash拆分为按ID取模的16个小Hash

- Lua脚本拆分为多个子脚本,加入

redis.breakpoint() - 启用I/O多线程(8核机器设置io-threads=6)

- 增加本地缓存减少Redis压力

优化后,P99延迟从1200ms降至9ms,CPU利用率从95%降至65%。

未来展望:Redis 8.0线程模型演进

根据2025年Redis社区路线图,Redis 8.0可能会在以下方面改进线程管理:

- 真正的多线程命令处理:在保持原子性的前提下实现并行执行

- 智能任务调度:根据命令类型自动分配计算资源

- 协程支持:更轻量级的并发模型

- 硬件加速:利用DPU等专用硬件卸载网络处理

Redis的线程管理就像是在走钢丝——需要在简单与高效、单线程与多线程之间找到完美平衡,理解其阻塞机制和优化方法,才能让这个"单线程忍者"发挥出真正的威力,在Redis的世界里,有时候少即是多,简单反而更快。

下次当你再遇到Redis卡顿时,希望这篇文章能帮你快速定位问题,而不是在深夜对着屏幕抓狂,毕竟,运维工程师的头发也是很宝贵的,不是吗?

本文由 华南蕾 于2025-08-06发表在【云服务器提供商】,文中图片由(华南蕾)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/554671.html

发表评论