消息队列|流处理 后浪云Apache Kafka教程:深入解析Apache Kafka 应用场景与实践

- 问答

- 2025-08-02 07:50:54

- 2

Apache Kafka实战指南

当订单洪峰遇上消息洪流

去年双十一,我朋友小王的电商平台差点崩了,凌晨刚过5分钟,订单量就突破了百万级别,数据库直接被打趴下,客服电话被打爆——不是顾客投诉,而是系统崩溃后无法下单的愤怒咨询,事后复盘时,技术总监只说了一句话:"我们需要一个能抗住流量海啸的消息系统。"

这就是Apache Kafka的用武之地,作为消息队列与流处理领域的"当红炸子鸡",Kafka已经成为互联网企业应对高并发场景的标准配置,但很多人对它的理解还停留在"高级消息队列"的层面,今天我们就来彻底拆解这个分布式流平台。

Kafka核心能力全景图

1 不只是消息队列

传统消息队列像邮局——确保信件投递就完事,而Kafka更像高速公路系统:

- 高吞吐:单集群轻松支持每秒百万级消息(参考2025年LinkedIn生产环境数据)

- 持久化存储:消息可保留数天甚至数周,不像RabbitMQ那样读完就丢

- 水平扩展:增加节点就能提升处理能力,不像ActiveMQ有单机瓶颈

- 流处理能力:能实时处理数据流,这是传统MQ不具备的

2 核心概念白话版

- Topic(主题):相当于数据库的表,user_click"主题存点击事件

- Partition(分区):把Topic拆成多个并行处理的文件,就像把大仓库隔成小隔间

- Producer(生产者):往Kafka丢数据的小程序,比如订单服务

- Consumer(消费者):从Kafka取数据的小程序,比如库存服务

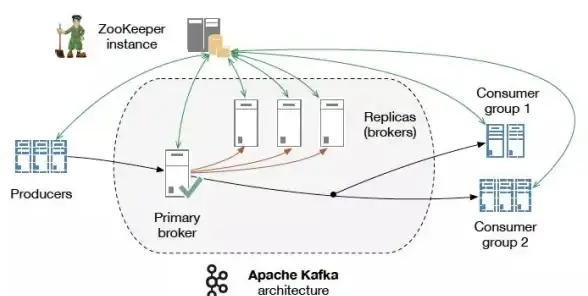

- Broker:Kafka服务器,多个Broker组成集群

真实场景下的Kafka实战

1 电商秒杀系统架构

以开头的电商场景为例,典型架构这样用Kafka:

[前端] → [订单服务] → Kafka → [库存服务][支付服务][物流服务][数据分析]关键配置要点:

- 订单主题设置10个分区,对应10个订单处理线程

- 消息保留2小时,足够所有下游系统消费

- 消费者组设置自动位移提交,避免重复消费

// 生产者示例(Spring Kafka)

@Autowired

private KafkaTemplate<String, Order> kafkaTemplate;

public void createOrder(Order order) {

kafkaTemplate.send("orders", order.getUserId(), order);

}

2 物联网设备数据处理

某智能家居公司用Kafka处理设备上报数据:

- 每个设备类型一个主题(temperature/humidity)

- 使用Kafka Connect直接入库到TimescaleDB

- 用KSQL实时计算房间平均温度

# 消费者示例(Python)

from kafka import KafkaConsumer

consumer = KafkaConsumer('temperature',

group_id='alert-group',

bootstrap_servers=['kafka1:9092'])

for msg in consumer:

temp = float(msg.value.decode())

if temp > 38: # 温度异常告警

send_alert(msg.key, temp)

3 金融交易风控系统

证券公司的实时风控方案:

- 交易数据先入Kafka,再同时给:

- Flink实时计算风险指标

- 批处理系统夜间跑T+1报表

- Elasticsearch提供实时查询

- 使用Exactly-Once语义保证数据精确性

性能调优避坑指南

1 配置黄金法则

- 分区数 = max(消费者数量, 磁盘吞吐量/单个分区吞吐)

- 副本数:生产环境至少2,关键业务3

- 刷盘策略:吞吐优先用异步,可靠性优先用同步

2 常见踩坑点

- 消费者滞后:增加分区或优化消费代码

- 磁盘写满:设置合理的留存策略(如按大小+时间双重限制)

- 重复消费:处理好消费位移提交逻辑

- 消息乱序:同一业务键的消息要发到同一分区

Kafka生态全家桶

现代Kafka早已超越消息队列,形成完整生态:

- Kafka Streams:轻量级流处理库,适合Java应用

- KSQL:用SQL处理流数据,非程序员也能用

- Connect:300+现成连接器,对接各种数据库

- Schema Registry:管理消息格式,避免"数据方言"

2025年新特性前瞻

根据2025年Kafka峰会信息,值得关注的新方向:

- 增量协作重平衡:消费者上下线不再导致全暂停

- 弹性分区:根据负载自动调整分区数

- GPU加速:用显卡加速流处理计算

- Wasm支持:用WebAssembly编写处理逻辑

写在最后

刚开始接触Kafka时,我被它的专业术语吓到过,但真正用起来才发现,它的设计非常符合直觉——就像高速公路既要保证车流畅通(高吞吐),又要设置服务区(持久化),还要有多个出口(多消费者)。

技术选型没有银弹,如果您的场景是:

- 需要处理日志/点击流等海量数据

- 多个系统需要共享数据

- 既要实时处理又要离线分析 那么Kafka绝对值得放入备选清单,反之,如果是简单的任务队列,可能RabbitMQ更合适。

再好的工具也要合理使用,某互联网金融公司曾因为Kafka配置不当,导致凌晨结算延迟,直接损失手续费收入——这不是Kafka的错,就像不能因为车祸就怪汽车发明者。

希望这篇指南能帮你避开那些我们曾经踩过的坑,下次见面,或许可以聊聊如何在Kafka上构建完整的流数据平台?

本文由 才柔静 于2025-08-02发表在【云服务器提供商】,文中图片由(才柔静)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/513696.html

发表评论