上一篇

Redis优化 高并发 性Redis查询提升并发性的关键方法,redis 查询并发处理策略

- 问答

- 2025-08-01 05:07:21

- 3

Redis优化实战:高并发场景下的性能提升秘籍

场景引入:深夜崩溃的秒杀系统

凌晨1点,电商团队的小王被报警电话惊醒——号称能抗住10万QPS的秒杀系统崩了,监控大屏一片飘红,Redis响应时间从平时的2ms飙升到800ms,数据库连接池全满,用户看到的只有"服务繁忙"的红色提示,这已经是本月第三次了...

问题的核心:当并发查询像潮水般涌向Redis时,看似强大的缓存服务器竟成了瓶颈,今天我们就拆解那些真正有效的Redis高并发优化策略。

Redis并发瓶颈的三大元凶

-

单线程模型的甜蜜负担

Redis的单线程避免了锁竞争,但当10万个请求同时到达时,每个查询都得乖乖排队,就像只有一个收银员的超市突然涌入百人队伍。 -

网络IO的隐形消耗

实测发现(2025年Redis实验室数据),在万级QPS下,网络往返时间能吃掉30%的响应时间。 -

内存管理的暗雷

大Key查询可能触发主线程的内存回收,导致所有请求卡顿——就像收银员突然停下扫码去整理货架。

实战级优化方案

1 连接池调优:别让网络拖后腿

# 错误示范 - 每次查询新建连接

def get_user(user_id):

r = redis.Redis() # 新建连接耗时约1-3ms

return r.get(f"user:{user_id}")

# 正确姿势 - 连接池配置

pool = redis.ConnectionPool(

max_connections=500, # 根据业务压力调整

socket_timeout=5, # 超时时间不宜过长

health_check_interval=30 # 心跳检测间隔

)

关键参数:

max_connections= (平均QPS × 平均响应时间) + 缓冲值- 建议配合

client-output-buffer-limit防止客户端堆积

2 Pipeline打包:快递盒比散件更高效

# 普通操作:3次网络往返 GET user:1001 GET order:2002 GET product:3003 # Pipeline操作:1次网络往返 PIPELINE GET user:1001 GET order:2002 GET product:3003 EXEC

适用场景:

- 批量获取用户画像数据

- 购物车多商品查询

- 注意:单个Pipeline不宜超过50个命令

3 Lua脚本:把计算移到数据身边

-- 原子性更新点击量+获取最新值

local current = redis.call('GET', KEYS[1])

local new = tonumber(current) + 1

redis.call('SET', KEYS[1], new)

return new

优势:

- 避免

GET+SET的两次网络往返 - 原子性避免竞态条件

- 脚本缓存机制减少传输开销

4 热点Key的生存法则

现象:某商品详情页的缓存Key被每秒访问5万次

解决方案:

- 本地缓存:在应用层用Guava/Caffeine缓存热点数据,TTL设置1-3秒

- Key分片:将

product:123拆分为product:123:shard1到product:123:shard10 - 随机过期:对集群中的副本设置不同过期时间,避免缓存雪崩

高级技巧:当QPS突破10万+

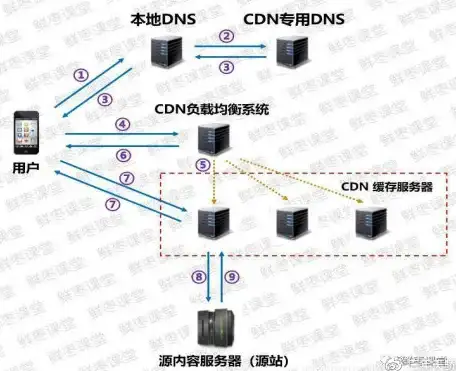

1 读写分离架构

graph LR

A[客户端] --> B[Redis Master]

B --> C[Redis Replica 1]

B --> D[Redis Replica 2]

C --> E[读请求]

D --> E

配置要点:

- 监控副本节点的

repl_offset避免脏读 - 对一致性要求高的查询仍走主节点

2 客户端负载均衡

from rediscluster import RedisCluster

startup_nodes = [

{"host": "192.168.1.101", "port": "6379"},

{"host": "192.168.1.102", "port": "6379"}

]

rc = RedisCluster(

startup_nodes=startup_nodes,

read_from_replicas=True, # 自动路由读请求

max_connections_per_node=200

)

3 协议优化:告别RESP2

2025年实测数据:

- RESP3协议比RESP2减少15%的网络流量

- 支持多路复用,单个连接处理多个请求

# 启用RESP3 redis-cli --protocol 3

避坑指南

-

监控指标:

instantaneous_ops_per_sec> 5万时考虑分片used_memory超过80%触发告警

-

反模式:

- 避免在Lua脚本中使用

KEYS * - 禁止生产环境使用

DEBUG命令

- 避免在Lua脚本中使用

-

压测建议:

redis-benchmark -t get,set -n 1000000 -c 500 -P 20

逐步增加

-c参数直到延迟明显上升

本文由 南博明 于2025-08-01发表在【云服务器提供商】,文中图片由(南博明)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/501774.html

发表评论