Redis 阻塞 深入探讨展开挑战模拟Redis阻塞,模拟redis阻塞的实现与优化

- 问答

- 2025-07-31 09:14:19

- 10

当Redis突然"罢工":一场阻塞危机的自救指南

老王最近遇到了件烦心事——他们电商平台的购物车服务突然变得奇慢无比,每当大促活动开始,系统就像被什么东西卡住了一样,用户抱怨连连,技术团队排查了半天,最后发现问题出在Redis上——它竟然"罢工"了!这到底是怎么回事?让我们一起来揭开Redis阻塞的神秘面纱。

Redis阻塞:那个让系统"卡死"的罪魁祸首

Redis以其高性能著称,但即便是这样的速度王者,在某些情况下也会突然"卡壳",想象一下,你正开车在高速公路上飞驰,突然前方出现施工,所有车辆不得不停下来等待——这就是Redis阻塞的生动写照。

Redis阻塞通常表现为:

- 客户端请求超时,应用日志中大量出现"Timeout"错误

- 监控面板上Redis的响应时间曲线突然飙升

- 系统吞吐量断崖式下跌,用户体验急剧恶化

"我们系统一直很稳定啊,怎么突然就这样了?"老王团队的小张挠着头不解地问,Redis阻塞往往不是突然发生的,而是长期积累的问题在关键时刻爆发。

动手实验:模拟Redis阻塞现场

理论说再多不如亲手实践,让我们搭建一个实验环境,亲自制造一场Redis阻塞危机。

1 实验准备

首先确保你有一个Redis实例运行着(版本5.0以上更好),我们可以使用redis-cli连接上去,执行以下命令监控阻塞情况:

redis-cli --latency -h 127.0.0.1 -p 6379

另开一个终端窗口,我们准备制造一些"麻烦"。

2 模拟大Key阻塞

大Key是常见的阻塞源头,让我们创建一个超级大的List:

# 插入一个包含10万元素的List

for i in {1..100000}; do redis-cli RPUSH biglist "element$i" > /dev/null; done

现在尝试获取这个List:

redis-cli LRANGE biglist 0 -1

你会发现这个命令执行得异常缓慢,期间其他客户端的所有请求都会被阻塞,这就是大Key的威力——一个操作就能让整个Redis实例瘫痪。

3 模拟慢查询

有些命令看似无害,但在特定条件下会变得极慢,比如对一个包含百万成员的Set执行SMEMBERS:

# 先创建一个大型Set

for i in {1..1000000}; do redis-cli SADD hugeset "member$i" > /dev/null; done

# 然后执行查询

redis-cli SMEMBERS hugeset

这个操作可能需要几秒钟才能完成,期间Redis无法处理其他请求。

4 模拟持久化阻塞

Redis的持久化操作(RDB或AOF)也可能导致阻塞,我们可以强制触发一个RDB保存:

redis-cli SAVE

执行这个命令时,Redis会暂停处理所有客户端请求,直到快照完成,在生产环境中,如果数据集很大,这个过程可能持续数秒。

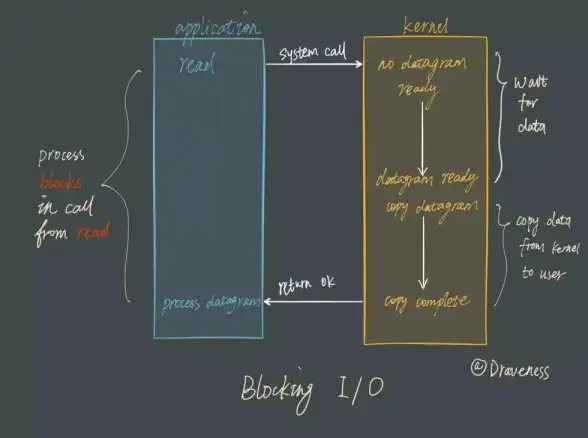

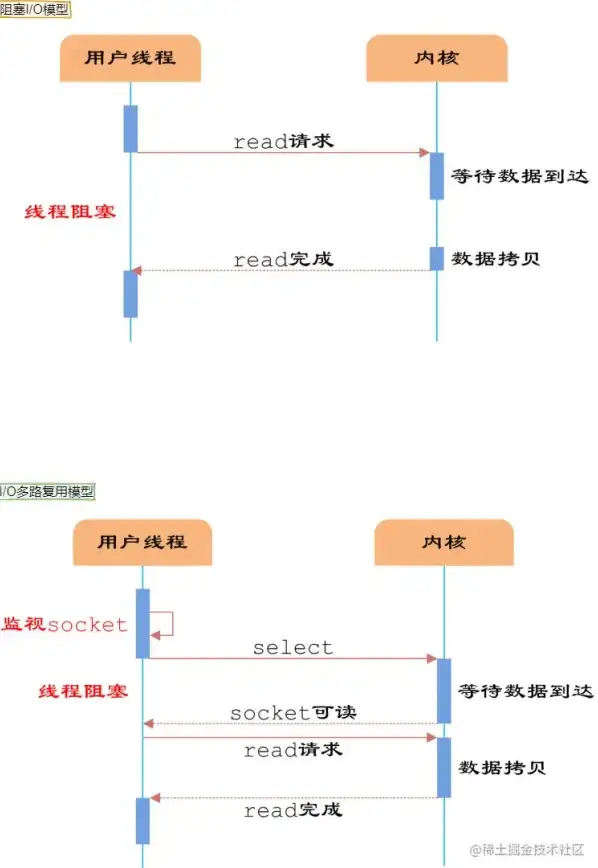

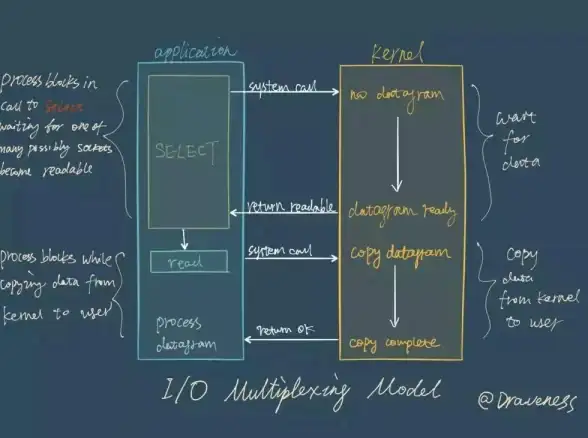

阻塞背后的真相:Redis单线程模型的AB面

为什么Redis会如此脆弱?这要从它的核心架构说起。

Redis采用单线程模型处理命令,这带来了极高的性能,因为避免了多线程的锁竞争和上下文切换开销,但硬币总有另一面——当某个命令执行时间过长,后续所有命令都必须排队等待。

"这不就像是只有一个收银台的超市吗?"老王团队的小李恍然大悟,确实如此,无论来了多少顾客,都只能一个一个结账,如果前面有人买了满满一购物车的商品,后面的人就只能干等着。

实战优化:让Redis重获新生

既然知道了问题所在,我们来看看如何优化,以下是经过实战检验的解决方案。

1 大Key拆分:化整为零

对于前面实验中的biglist,我们可以将其拆分为多个小List:

# 将原List拆分为100个小型List

for i in {1..100}; do

redis-cli RPUSH "biglist:$i" "element$((i*1000))" > /dev/null

done

查询时只需要知道目标数据在哪个分片即可,这种方法特别适合海量数据的存储场景。

2 慢查询优化:选择合适的命令

Redis提供了许多命令变体,有些更适合大数据量场景。

- 使用SSCAN代替SMEMBERS遍历大Set

- 使用HSCAN代替HGETALL获取大Hash

- 使用ZSCAN代替ZRANGE获取大ZSet

这些SCAN系列命令可以分批获取数据,避免一次性操作阻塞Redis。

3 持久化优化:平衡性能与可靠性

对于持久化导致的阻塞,可以考虑以下策略:

- 使用AOF持久化并设置appendfsync为everysec(默认值),在性能和数据安全间取得平衡

- 对于RDB,避免在生产高峰执行SAVE,改用BGSAVE后台保存

- 在从节点上执行持久化操作,减轻主节点压力

4 客户端优化:合理设置超时

应用端应该设置合理的超时时间并实现重试机制:

JedisPoolConfig poolConfig = new JedisPoolConfig(); poolConfig.setMaxTotal(128); poolConfig.setMaxIdle(32); poolConfig.setMinIdle(8); poolConfig.setTestOnBorrow(true); poolConfig.setTestWhileIdle(true); // 设置连接超时和读写超时 JedisPool jedisPool = new JedisPool(poolConfig, "localhost", 6379, 2000, 1000);

5 监控告警:防患于未然

建立完善的监控体系可以提前发现问题:

- 监控Redis的slowlog,定期分析慢查询:

redis-cli SLOWLOG GET 10

- 监控内存使用情况,警惕大Key

- 设置响应时间阈值告警

高级技巧:Lua脚本优化之道

Redis的Lua脚本执行是原子性的,这意味着脚本执行期间会阻塞其他命令,优化Lua脚本至关重要。

1 避免长时间运行的脚本

Lua脚本应该尽量简短高效,如果必须处理大量数据,可以考虑:

- 将大任务拆分为多个小脚本

- 在脚本中使用redis.call('TIME')检查执行时间,必要时提前退出

- 设置脚本执行超时:

redis-cli --eval script.lua , 10(10秒超时)

2 使用SCRIPT KILL终止问题脚本

当发现某个脚本执行时间过长,可以通过以下命令终止它:

redis-cli SCRIPT KILL

注意:这只能终止尚未执行写操作的脚本。

集群环境下的阻塞应对策略

在Redis集群环境中,阻塞问题更加复杂,以下是针对性建议:

- 热点Key分散:使用哈希标签确保相关Key分布在同一个节点,但整体负载均衡

- 读写分离:将读请求导向从节点,减轻主节点压力

- 多实例隔离:将不同类型的数据存储在不同的Redis实例中,避免相互影响

实战案例:电商平台购物车优化实录

回到老王的电商平台问题,他们最终通过以下步骤解决了Redis阻塞:

- 分析慢日志:发现购物车HGETALL操作在大促期间特别慢

- 数据结构重构:将单个用户购物车的Hash结构拆分为多个小Hash

- 命令优化:用HSCAN代替HGETALL,分批获取数据

- 本地缓存:对购物车数据增加应用层缓存,减少Redis访问

- 限流降级:在Redis响应变慢时自动启用降级策略

经过这些优化,系统在大促期间的稳定性显著提升,Redis阻塞问题基本消失。

与Redis和平共处的艺术

Redis阻塞就像系统性能的"暗礁",平时看不见,一旦撞上就可能造成严重后果,通过本文的探讨,我们了解到:

- Redis阻塞有多种成因,需要具体情况具体分析

- 模拟阻塞场景是理解和解决问题的有效途径

- 优化策略需要从数据结构、命令选择、持久化配置等多方面入手

- 完善的监控体系可以提前预警潜在问题

预防胜于治疗,与其等问题发生后再手忙脚乱地补救,不如提前做好防护措施,让Redis始终保持在最佳状态。

"原来Redis优化有这么多门道!"老王感叹道,确实,技术没有银弹,只有深入理解原理,结合实际场景不断调优,才能打造出真正稳定高效的系统。

本文由 祖高义 于2025-07-31发表在【云服务器提供商】,文中图片由(祖高义)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/493163.html

发表评论