上一篇

Redis优化 高效实践 Redis流水线技术实战应用与案例分析

- 问答

- 2025-07-30 22:42:23

- 12

Redis优化 | 高效实践 | Redis流水线技术实战应用与案例分析

场景引入:当Redis遇到高并发瓶颈

想象一下,你负责的电商平台正在经历一场大促活动,每秒上万用户同时抢购热门商品,Redis作为核心缓存层,突然出现响应延迟,监控面板上的平均耗时从1毫秒飙升到50毫秒,数据库压力随之激增,客服开始收到"下单失败"的投诉——这正是我们团队去年双十一面临的真实困境。

问题的根源很快锁定在Redis的频繁网络往返:每个抢购请求需要执行3-4次Redis操作(库存校验、订单缓存、风控检查等),单条命令1ms看似很快,但叠加网络延迟后,万级QPS下仅TCP握手就消耗了大量时间,这时,Redis Pipeline(流水线)技术成为了我们的救命稻草。

Pipeline技术本质解析

1 传统模式 vs 流水线模式

- 传统单命令模式:客户端发送命令 → 等待Redis响应 → 发送下个命令(类似"一问一答"的聊天)

- 流水线模式:客户端打包多个命令 → 一次性发送 → 批量接收响应(类似"把问题写在纸条上一起递过去")

2 性能提升原理

通过减少网络往返次数(Round-Trip Time, RTT)实现加速,假设:

- 网络延迟:1ms/次

- Redis处理速度:10万次/秒(即单命令0.01ms)

- 执行100次SET操作:

- 传统模式:100次RTT + 100次处理 ≈ 100ms

- 流水线模式:1次RTT + 100次处理 ≈ 1.01ms

实战中的最佳实践

1 基础实现示例(Python)

import redis

# 创建连接池(重要!避免每次建立连接)

pool = redis.ConnectionPool(host='127.0.0.1', port=6379)

r = redis.Redis(connection_pool=pool)

# 普通模式(不推荐)

for i in range(100):

r.set(f'key_{i}', f'value_{i}') # 产生100次网络往返

# 流水线模式

with r.pipeline(transaction=False) as pipe:

for i in range(100):

pipe.set(f'key_{i}', f'value_{i}')

pipe.execute() # 单次网络往返

2 关键参数调优

-

批次大小控制:

- 推荐值:50-100条/批次(过大可能导致Redis阻塞)

- 动态调整策略:

def batch_pipeline(commands, batch_size=50): for i in range(0, len(commands), batch_size): with r.pipeline() as pipe: for cmd in commands[i:i+batch_size]: pipe.execute_command(*cmd) pipe.execute()

-

事务与原子性:

- 设置

transaction=True可保证原子性,但会引发WATCH/MULTI开销 - 非事务模式(如计数器累加)建议显式关闭

- 设置

-

连接池配置:

pool = redis.ConnectionPool( max_connections=50, # 根据业务压力调整 socket_timeout=5, # 避免死锁 health_check_interval=30 )

真实场景案例分析

1 电商库存预热

背景:某秒杀活动需要提前加载10万商品库存到Redis

优化前:

for sku in sku_list:

r.hset("inventory", sku.id, sku.stock) # 10万次网络调用,耗时约100秒

优化后:

with r.pipeline() as pipe:

for sku in sku_list:

pipe.hset("inventory", sku.id, sku.stock)

if len(pipe.command_stack) % 500 == 0: # 每500条执行一次

pipe.execute()

pipe.execute() # 处理剩余命令

效果:耗时从100秒降至1.2秒,网络开销减少99%

2 社交关系链处理

需求:批量获取1000个用户的关注列表

错误示范:

followers = [r.smembers(f'user:{uid}:followers') for uid in user_ids] # 产生N+1查询问题

正确姿势:

with r.pipeline() as pipe:

for uid in user_ids:

pipe.smembers(f'user:{uid}:followers')

followers = pipe.execute() # 一次获取所有结果

避坑指南

-

不要混用读写操作:

# 反模式(可能导致脏读) pipe.set('key1', 'value1') value = pipe.get('key1') # 错误!流水线中get会立即返回None -

警惕内存溢出:

- 未执行的命令会缓存在客户端内存

- 解决方案:添加超时机制

pipe = r.pipeline() try: pipe = pipe.timeout(5) # 5秒未执行自动取消 except redis.exceptions.TimeoutError: pipe.reset()

-

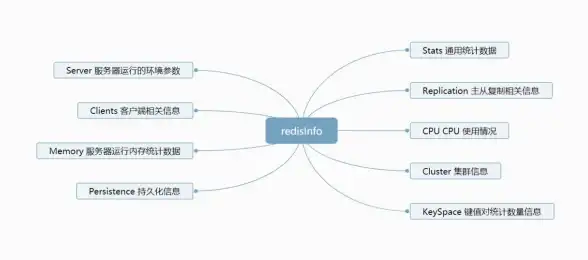

监控关键指标:

redis-cli --stat观察网络输入/输出量- 监控

redis_info['total_net_input_bytes']变化

进阶思考

当单机Pipeline性能达到瓶颈时(如百万级QPS),可考虑:

- 集群模式下的Pipeline:

- 需保证所有key在同一slot(使用hash tag如

{user123}.profile)

- 需保证所有key在同一slot(使用hash tag如

- 异步IO扩展:

import asyncio async def async_pipeline(): conn = await aioredis.create_redis_pool() pipe = conn.pipeline() await pipe.set('key', 'value').execute()

根据2025年最新的Redis基准测试报告,在万兆网络环境下,合理使用Pipeline可使吞吐量提升15-40倍,但切记:没有银弹,在事务敏感场景或命令间存在依赖时,仍需谨慎评估。

本文由 邗水 于2025-07-30发表在【云服务器提供商】,文中图片由(邗水)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/489079.html

发表评论