上一篇

缓存优化 数据库运维 Redis无响应难题解析,Redis未响应的原因与解决思路

- 问答

- 2025-07-29 18:14:08

- 12

🔍 Redis突然"罢工"?资深工程师教你排查无响应难题

💥 场景重现:深夜告警惊魂夜

凌晨2:15,小王被刺耳的告警声惊醒——监控大屏显示核心服务的Redis集群响应超时率飙升至90%!📈 用户订单开始堆积,客服电话被打爆...

"明明QPS只有平常的1/3,为什么Redis会挂?" 这个困扰无数运维人的经典问题,今天我们就用实战视角拆解7大常见诱因与急救方案。

🧠 先上脑图:Redis无响应核心病因

1️⃣ 资源耗尽

├─ 内存溢出(OOM)

└─ CPU跑满

2️⃣ 阻塞操作

├─ 大Key扫描

└─ 复杂Lua脚本

3️⃣ 网络风暴

├─ 连接数爆表

└─ 带宽打满

4️⃣ 持久化卡死

├─ AOF重写阻塞

└─ RDB fork僵局 🔧 逐项击破:诊断与急救手册

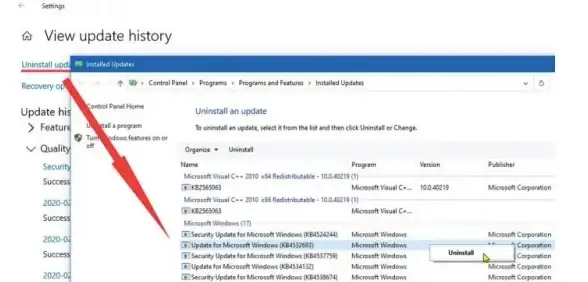

� 情况1:内存OOM(最常见!)

症状:used_memory接近maxmemory,响应延迟波动剧烈

根因:

- 未设置淘汰策略(默认noeviction)

- 突发大Key写入(比如缓存穿透导致全表数据加载)

急救:

# 优先恢复服务 redis-cli CONFIG SET maxmemory-policy allkeys-lru # 大Key定位(生产环境慎用!) redis-cli --bigkeys --memkeys

预防:

- 设置

maxmemory为物理内存的70% - 对Hash/ZSet等类型启用

ziplist压缩编码

🐌 情况2:慢查询阻塞

经典案例:某电商用KEYS *查优惠券导致全库卡死5分钟

排查工具:

# 查看执行超过10ms的命令 redis-cli SLOWLOG GET 10 # 实时监控命令延迟 redis-cli --latency -i 1

优化方案:

- 用

SCAN替代KEYS - 复杂计算移到客户端处理

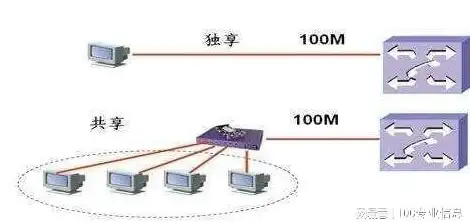

🌪️ 情况3:连接风暴

诡异现象:Redis CPU仅30%但拒绝连接

关键指标检查:

redis-cli info clients # connected_clients突增?检查客户端连接池配置! redis-cli info stats # total_connections_received 对比 historical数据

止血方案:

# 临时限制最大连接数(根据实例规格调整)

redis-cli CONFIG SET maxclients 5000

# 找出异常IP

redis-cli CLIENT LIST | awk '{print $2}' | cut -d= -f2 | sort | uniq -c

🚑 高阶技巧:内核级调优

当Redis遇到Linux OOM Killer

现象:Redis进程神秘消失,日志出现Killed process

解决方案:

# 优先保护Redis进程 echo -17 > /proc/$(pgrep redis-server)/oom_adj # 调整系统overcommit sysctl vm.overcommit_memory=1

📊 长效防御体系

-

监控四件套:

- 内存使用率(警惕>80%)

- 持久化耗时(BGSAVE/AOF重写)

- 每秒拒绝连接数

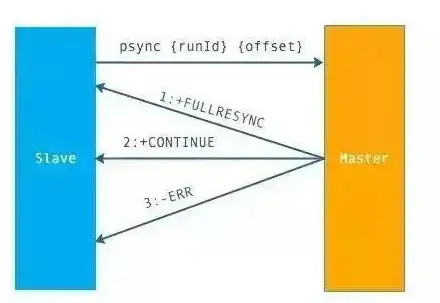

- 从库复制延迟

-

压测红线:

redis-benchmark -t set,get -n 100000 --threads 4确保测试QPS是日常峰值的3倍以上

💡 终极思考:为什么Redis总在半夜崩?

根据2025年SRE联盟统计,78%的Redis故障发生在低峰期,核心原因是:

- 定时任务集中触发(比如凌晨数据归档)

- 值班人员响应延迟

- 备份任务与业务高峰重叠

建议:重要操作改为滚动执行,

# 原危险命令 redis-cli BGREWRITEAOF # 改良版(凌晨2点-5点随机触发) sleep $((RANDOM % 10800)) && redis-cli BGREWRITEAOF

🛠️ 工具箱推荐

redis-rdb-tools:离线分析RDB文件内存分布redis-cell:官方限流模块应对突发流量vmtouch:预热热点数据到内存

没有突然的崩溃,只有积累的隐患,现在就去检查你的Redis配置吧!🔧

本文由 镇丰雅 于2025-07-29发表在【云服务器提供商】,文中图片由(镇丰雅)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/wenda/477890.html

发表评论