🔥实用指南🔥本地部署丨深度学习丨环境配置 deepseek》快速入门全攻略

- 手游动态

- 2025-08-13 07:40:36

- 5

🔥【深夜部署实录】本地AI炼丹炉搭建指南:DeepSeek从入门到跑通全流程🔥

🌙凌晨2:47,你盯着屏幕上闪烁的光标,第三次输入"pip install deepseek"后,终端又双叒叕报错了……别砸键盘!这篇保姆级教程带你2小时搞定本地部署,让AI小助手在你电脑里安家!(配图:深夜电脑屏幕前抓狂的猫咪GIF)

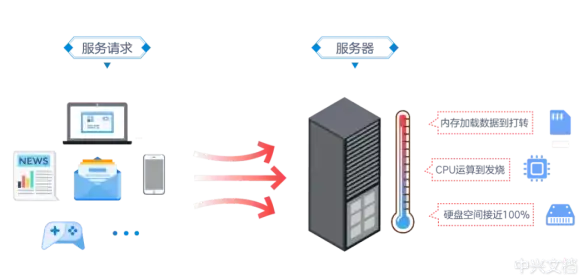

🛠️ 部署前必看:硬件体检报告

先给电脑做个"深度体检",不同体型AI模型对硬件要求差异堪比哈士奇和吉娃娃:

-

🐕 轻量级选手(1.5B-7B参数):

- 显卡:≥4GB显存(GTX 1650/RTX 3050起跳)

- 内存:16GB(8GB也能跑,但会像老牛拉破车)

- 存储:预留20GB给模型文件

-

🐕🦺 专业级选手(14B-67B参数):

- 显卡:RTX 3090/4090或A100(显存≥24GB)

- 内存:32GB+(DDR5更佳)

- 存储:SSD才能扛住高频读写

⚠️ 避坑警告:

- 核显玩家慎入!用Intel集成显卡跑DeepSeek≈让蜗牛参加F1

- 机械硬盘会拖慢推理速度,就像给法拉利装拖拉机轮胎

🚀 三步搭建AI小窝

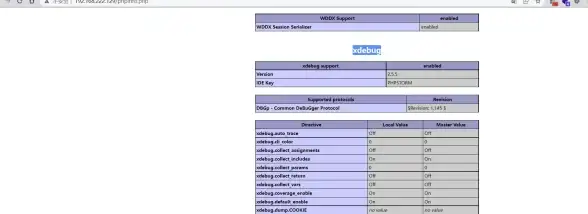

Step 1:安装炼丹炉(环境配置)

1️⃣ 打造Python结界

# 创建虚拟环境(别用base环境作死!) conda create -n deepseek_env python=3.10 conda activate deepseek_env

2️⃣ 召唤CUDA神兽

- 🔍 查显卡型号:

nvidia-smi - 📥 下载对应CUDA:NVIDIA官网→CUDA Toolkit Archive

- 🧙 魔法咒语:

# 以CUDA 12.1为例 wget https://developer.download.nvidia.com/compute/cuda/12.1.0/local_installers/cuda_12.1.0_530.30.02_linux.run sudo sh cuda_12.1.0_530.30.02_linux.run

3️⃣ 配置PyTorch法阵

# 清华镜像加速安装 conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/ conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia

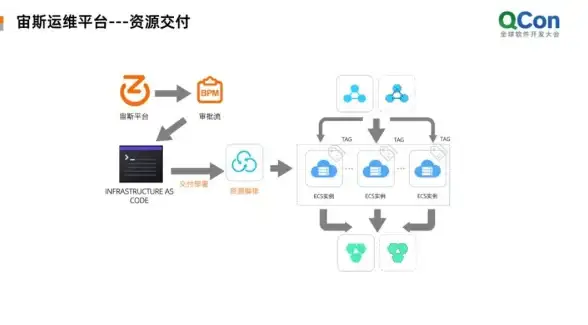

Step 2:部署DeepSeek本体

🔥 新手友好方案:Ollama一键安装

# 下载安装包(三选一) curl -fsSL https://ollama.com/install.sh | sh # Linux/macOS # 或访问GitHub Release页下载Windows版

# 部署模型(1.5B小模型示例) ollama run deepseek-r1:1.5b

🔧 进阶方案:LM Studio图形化部署

1️⃣ 下载安装包→选择模型目录→拖拽模型文件

2️⃣ 设置界面勾选"使用GPU加速"(显存不够会自动切换CPU)

3️⃣ 输入测试指令:

"用Python写个冒泡排序,并逐行解释代码逻辑"

Step 3:魔法调参

🎛️ 关键参数说明书:

| 参数 | 作用 | 推荐值 |

|------|------|--------|

| max_new_tokens | 回答长度 | 512(论文阅读)/2048(长文写作) |

| temperature | 创造力 | 0.2(严谨学术)/0.8(创意写作) |

| top_p | 回答多样性 | 0.95(通用场景) |

💡 实战技巧大放送

1️⃣ 显存不够?

- 启用

--precision fp16半精度模式(RTX 30系显卡专属福利) - 使用

--model deepseek-r1:1.5b小模型应急

2️⃣ 加速秘籍

# 启用Flash Attention加速 export TORCH_COMPILE_ENABLE_FLASH_ATTN=1

3️⃣ 多模型切换

在模型目录新建models文件夹,放入不同参数模型文件,通过ollama switch命令切换

🚨 故障排除红绿灯

🔴 红灯警报:

- 报错

CUDA out of memory→ 降低max_new_tokens或换小模型 - 模型加载卡在99% → 检查杀毒软件是否误杀进程

🟡 黄灯预警:

- 首次推理慢如蜗牛 → 正常,二次调用会缓存加速

- 回答出现乱码 → 调整

temperature到0.5以下

🟢 绿灯畅行:

- 看到

DeepSeek initialized提示 → 部署成功! - 终端显示

GPU utilization: 98%→ 火力全开状态

🎉 部署成功庆祝仪式

现在你可以:

- 📚 让AI帮你读论文:"总结这篇Nature论文的创新点,并给出3个可改进方向"

- 💻 调试代码神器:"用Python实现YOLOv8目标检测,要求支持CUDA加速"

- 🎨 创意助手:"以赛博朋克风格写个关于AI觉醒的短篇小说"

🌅 看着窗外渐亮的天色,你的本地AI炼丹炉已经炉火纯青,从此告别云端延迟,享受私有化AI的丝滑体验!记得定期用ollama update给模型做"体检",下次我们聊聊如何用DeepSeek搭建私人知识库~(配图:朝阳下电脑屏幕显示"Hello, I'm your local AI")

本文由 暴风皎洁 于2025-08-13发表在【云服务器提供商】,文中图片由(暴风皎洁)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/ssdt/601039.html

发表评论