🔧实用技巧♦深度解析♦本地部署 deepseek》全流程详解,轻松上手必看!

- 手游动态

- 2025-08-09 23:13:19

- 7

🔧实用技巧♦️深度解析♦️本地部署《DeepSeek》全流程详解,轻松上手必看!

🌧️场景引入:

又是一个加班的深夜,你盯着电脑屏幕上的API调用失败提示,心里默默吐槽:“明明是我的数据,为啥要传到云端才能分析?”😤 突然,同事发来一条消息:“试试本地部署DeepSeek啊!再也不用担心隐私泄露,还能白嫖高性能推理!”💡 你眼前一亮,但一想到复杂的命令行和配置,又瞬间头大……别慌!这篇保姆级教程手把手带你从零搞定,连隔壁桌的文科生都能学会!👩💻✨

📌 Part 1:部署前必看!这些坑千万别踩

硬件配置自查表

| 场景 | 内存 | 显卡 | 存储空间 | 💡提示 |

|---|---|---|---|---|

| 基础体验 | 16GB | 集成显卡 | 100GB | 跑1.5B小模型,写写文案够用 |

| 进阶开发 | 32GB | RTX 3060 6GB | 200GB | 7B模型代码生成无压力 |

| 硬核玩家 | 64GB | RTX 4090 24GB | 500GB | 32B大模型随便浪 |

⚠️ 避坑指南:

- 显存不够?试试

--max_batch 16限制批次,或用--gpu_memory 8G强制显存分配 - 模型加载失败?检查模型文件后缀是否为

.gguf或.bin,别用ZIP直接改后缀!

🚀 Part 2:三步走!傻瓜式部署流程

🔧 Step 1:安装Ollama(AI模型管家)

- 官网下载:https://ollama.com

- 安装时千万别改路径!默认C盘才能避免环境变量灾难

- 验证安装:

Win+R输入cmd,敲入ollama -v,看到版本号就成功啦!

📥 Step 2:下载DeepSeek模型

🔥 热乎的模型列表(2025.08更新):

| 型号 | 参数 | 显存需求 | 特长 |

|-------------|-------|----------|-----------------------|

| R1-1.5B | 15亿 | 2GB | 轻量对话,核显可战 |

| R1-7B | 70亿 | 8GB | 代码生成,数学推理 |

| V3-671B | 6710亿| 1.5TB | 科研级超大规模模型 |

💡 小技巧:

- 在Ollama界面直接搜

deepseek,按显存需求筛选模型 - 企业级部署推荐

docker pull deepseek/official:r1-7b-2025q2,镜像一键拉取

🖥️ Step 3:启动模型(附可视化神器)

方案A:极客模式(命令行)

ollama run deepseek-r1:7b

看到Success!后,输入/chat开始对话:

> 解释量子计算在金融领域的应用 方案B:小白福音(Chatbox)

- 下载:https://chatboxai.app

- 设置→模型提供方选

Ollama→勾选你安装的模型 - 界面比官方网页版还丝滑!🎉

🔧 Part 3:性能优化秘籍

显存不够?量化来凑!

在Ollama命令后加参数:

ollama run deepseek-r1:7b --quantize q4_0

💡 效果:显存占用直降60%,16GB内存也能跑7B模型!

加速神器:DirectML(核显福音)

ollama serve --device directml

AMD核显瞬间变身小钢炮,实测速度比CPU快3倍!

企业级高可用部署

# docker-compose.yml片段

services:

deepseek:

image: deepseek/official:r1-7b-2025q2

deploy:

replicas: 3

resources:

limits:

nvidia.com/gpu: 1

💡 三节点集群自动容灾,单点故障?不存在的!

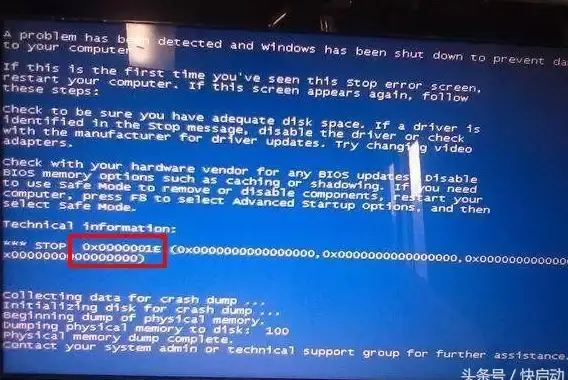

🚨 Part 4:常见报错解决方案

❌ 错误1:CUDA out of memory

✅ 解决方案:

- 临时救急:

ollama run --gpu_memory 4G deepseek-r1:7b - 根治方案:升级显存,或换用

--cpu模式(牺牲速度保命)

❌ 错误2:Model file not found

✅ 解决方案:

- 检查模型路径是否含中文或特殊符号

- 手动下载模型到

C:\Users\用户名\.ollama\models

❌ 错误3:API响应超时

✅ 解决方案:

- 调整配置文件:

vim ~/.ollama/config.ymlmax_batch_size: 8 max_context_length: 2048

🎉 大功告成!现在你可以……

- 🔒 离线分析公司财报,再也不怕数据泄露

- 🤖 定制专属AI助手,帮我写一份Python爬虫教程,要适合零基础学员”

- 🚀 搭建本地知识库,10秒生成行业报告(上传PDF到

/data/knowledge目录)

💡 进阶玩法:

用curl调用本地API,把DeepSeek集成到你的工作流程中:

curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1:7b",

"prompt": "用三句话解释区块链的共识机制"

}'

📌 最后提醒:

- 每月到Ollama官网检查模型更新(2025.08新增

deepseek-r1-distill-qwen-14b) - 企业用户务必配置

TLS加密和ACL访问控制(教程见官方文档第4.3章)

关掉浏览器,打开你的电脑,跟着这篇攻略一步步操作吧!🚀 有什么问题欢迎在评论区留言,老司机在线答疑~💬

本文由 缓存故障艺术家 于2025-08-09发表在【云服务器提供商】,文中图片由(缓存故障艺术家)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/ssdt/580696.html

发表评论