上一篇

同步机制必看|深度盘点Zookeeper大数据实战—核心揭秘【技术解析】

- 云服务器供应

- 2025-08-14 11:13:16

- 3

同步机制必看|深度盘点Zookeeper大数据实战——核心揭秘【技术解析】

🌧️ 开篇:当分布式系统遭遇“数据暴雨”

想象这样一个场景:某电商大促期间,订单系统每秒产生数十万次状态变更,库存服务、物流服务、支付服务需要像交响乐团般精准同步每一个音符,但现实往往像暴雨中的露天音乐会——网络延迟、节点宕机、数据版本冲突等问题此起彼伏,这时候,Zookeeper的同步机制就像一位经验丰富的指挥家,用“分布式魔法棒”让所有服务保持节奏一致,我们就来深度解密这位“指挥家”的核心技术。

🔍 核心揭秘:Zookeeper同步机制的三大法宝

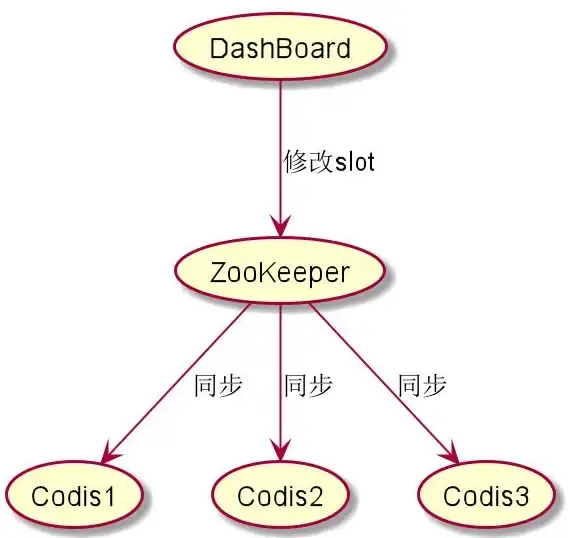

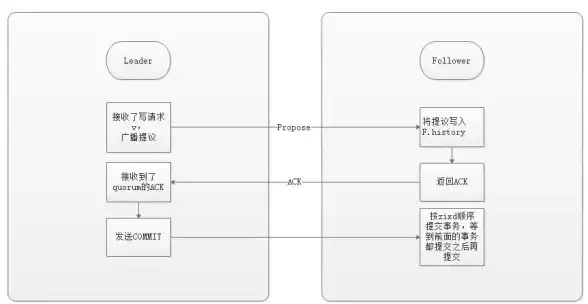

ZAB协议:数据同步的“交通法规”

Zookeeper Atomic Broadcast(ZAB)协议是数据同步的基石,其运作逻辑堪比城市交通信号系统:

- Leader单点受理:所有写请求先发往Leader节点,避免多节点并发修改引发的“车祸”

- 事务日志接力:Leader将操作记录为事务日志,像高速公路ETC收费站般按序号广播给所有Follower

- 过半数确认机制:当超过半数节点完成数据同步(类似交通信号灯的黄灯过渡期),Leader才会提交事务

- 故障快速恢复:通过ZXID(事务唯一标识)实现断点续传,新Leader会从最大ZXID处恢复数据同步

Watcher机制:事件驱动的“神经网络”

Zookeeper的Watcher机制如同分布式系统的神经末梢,实现精准的事件感知:

- 三级监听体系:节点数据变化(NodeDataChanged)、子节点增减(NodeChildrenChanged)、节点存续状态(NodeCreated/Deleted)

- 防抖动设计:采用“一次注册,多次触发”机制,避免频繁轮询带来的性能损耗

- 层级化监听:支持类似

/service/**的路径通配符监听,实现服务实例的批量感知

临时节点:动态拓扑的“魔法粉尘”

EPHEMERAL节点特性为分布式系统注入魔法:

- 服务注册:服务实例启动时创建临时节点,宕机时自动删除,实现“零配置”健康检查

- 负载均衡:消费者通过

getChildren()获取服务列表,天然支持动态扩缩容 - 会话超时:Session过期时间建议设置为网络RTT的3倍,典型生产环境配置5-15秒

🚀 大数据实战:Zookeeper同步机制的应用图谱

场景1:金融级分布式锁(某支付系统实战)

# 伪代码示例:基于顺序节点的公平锁

def acquire_lock():

node = zk.create("/lock/seq-", ephemeral=True, sequence=True)

while True:

children = zk.get_children("/lock", sort=True)

if node == children[0]:

return True

else:

prev_node = "/lock/" + children[children.index(node)-1]

zk.get(prev_node, watch=True) # 监听前驱节点

wait()

- 防死锁设计:设置业务超时时间=理论最大耗时×120%

- 性能优化:采用哈希分片将锁粒度细化到业务模块级

- 容灾方案:跨AZ部署时,Observer节点承担只读流量,主节点故障时3秒内完成Failover

场景2:Kafka消费者组协调(万亿级消息同步)

- Offset管理:将消费位移存储在Zookeeper节点,利用Watcher实现消费者重平衡

- 分区分配:通过

/consumers/[group]/ids节点维护消费者成员关系 - 故障转移:当消费者会话超时,临时节点自动删除,触发其他实例接管分区

场景3:Hadoop YARN资源调度(千节点集群实践)

- 资源注册:NodeManager创建

/rm/node/[hostname]临时节点,携带CPU/内存资源信息 - 心跳机制:每3秒更新节点数据,超时10分钟未更新则标记为Lost

- 动态扩缩容:通过

getChildren()批量感知新增/下线节点,实现资源池的弹性伸缩

💡 性能优化:让同步机制跑出“F1赛车的速度”

连接管理

- 指数退避重试:遭遇连接失败时,按1s/2s/4s/8s间隔重试,避免“雪崩式”重试

- Session池化:使用连接池技术,复用TCP长连接,减少三次握手开销

- 地域感知路由:多机房部署时,优先连接同机房节点,跨机房流量控制在20%以内

数据操作

- 批量提交:将多个写操作合并为单个事务,减少网络往返次数

- 本地缓存:对配置类数据采用“拉取+推送”混合模式,90%读取走本地缓存

- 压缩传输:启用Snappy压缩算法,使数据包体积减少60%-70%

监控体系

- 四维监控指标:

- 延迟:P99不超过100ms

- 吞吐量:每秒处理事务数(TPS)

- 节点同步时延:Leader与Follower数据差异不超过1个ZXID

- Watcher触发次数:异常飙升可能暗示节点风暴

Zookeeper同步机制的进化方向

-

云原生集成:

- 与Kubernetes深度整合,通过Operator实现自动化部署

- 支持CSI插件,将Zookeeper数据持久化到云存储

-

AI赋能:

- 基于历史流量预测,动态调整Watcher监听频率

- 异常检测:用机器学习识别“长尾延迟”等隐蔽问题

-

新硬件适配:

- 优化持久内存(PMEM)的使用,将WAL日志写入速度提升10倍

- 支持RDMA网络,将跨节点同步延迟降至微秒级

📚 扩展阅读:技术选型对比

| 特性 | Zookeeper | Etcd | Consul |

|---|---|---|---|

| 一致性模型 | 强一致性 | 线性一致性 | 最终一致性 |

| 同步机制 | ZAB协议 | Raft协议 | Gossip协议 |

| 适用场景 | 分布式协调 | 配置管理 | 服务发现 |

| 百万级节点支持 | 挑战较大 | 良好 | 优秀 |

🎯 Zookeeper同步机制的“灵魂三问”

-

为什么需要Zookeeper?

当分布式系统超过3个节点时,手动维护状态一致性的复杂度呈指数级增长,Zookeeper提供“开箱即用”的协调服务。

-

同步延迟如何控制?

通过优化网络拓扑、调整批量提交阈值、合理设置Watcher等手段,可将P99延迟控制在100ms以内。 -

未来会被取代吗?

在需要强一致性、复杂协调的场景(如分布式锁、Leader选举),Zookeeper仍将是首选,但在轻量级配置管理领域,Etcd等新秀正在快速崛起。

📌 技术寄语:分布式系统的复杂度不会消失,只会转移,Zookeeper的同步机制,正是将这种复杂度封装成可编程接口的典范,理解其设计哲学,比掌握API调用更重要。

本文由 云厂商 于2025-08-14发表在【云服务器提供商】,文中图片由(云厂商)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://up.7tqx.com/fwqgy/613171.html

发表评论